Chept GPT作为近年来

人工智能领域的重要突破,引发了广泛关注。它不仅在自然语言处理任务上取得了显著成果,还让我们对

人工智能的未来充满了期待。本文将深入探讨Chept GPT背后的技术奥秘,揭开其神秘的面纱。

首先,我们需要了解Chept GPT的基本原理。Chept GPT是一种基于变换器(Transformer)架构的预训练语言模型,其核心思想是通过大规模语料库对模型进行预训练,从而学习到丰富的语言知识和结构。在预训练过程中,Chept GPT采用了无监督学习的方法,即不需要人工标注的数据进行训练。这种方法使得模型能够自动从大量文本中学习到有用的信息。

接下来,我们来详细解析Chept GPT的关键技术。

1. 变换器(Transformer)架构:Transformer是一种基于自注意力机制的深度神经网络模型。它主要由编码器(Encoder)和解码器(Decoder)两部分组成。在Chept GPT中,只使用了编码器部分。编码器由多个自注意力层和前馈神经网络层组成,能够有效地捕捉文本中的长距离依赖关系。

2. 预训练目标:Chept GPT采用了两种预训练目标,分别是掩码语言建模(Masked Language Modeling,MLM)和下一句预测(Next Sentence Prediction,NSP)。MLM任务是通过掩码一部分单词,让模型预测被掩码的单词。这种方法能够使模型学习到单词的上下文信息。NSP任务则是让模型预测两个句子是否是连续的,从而学习到句子间的关系。

3. 位置编码:为了使模型能够理解文本中的顺序信息,Chept GPT引入了位置编码。位置编码是一种将单词位置信息编码为向量并添加到词向量中的方法。这样,模型在处理文本时,可以同时考虑到单词的顺序和内容。

4. 层次化注意力机制:Chept GPT采用了层次化注意力机制,使得模型在处理长文本时,能够更有效地捕捉关键信息。层次化注意力机制将文本划分为多个层次,每个层次关注不同的信息。在处理每个层次时,模型会根据上下文信息动态调整注意力权重。

5. 微调(Fine-tuning):Chept GPT在预训练完成后,还需要进行微调。微调是将预训练模型应用于特定任务时,对模型进行少量调整的过程。通过微调,模型能够更好地适应具体任务的需求。

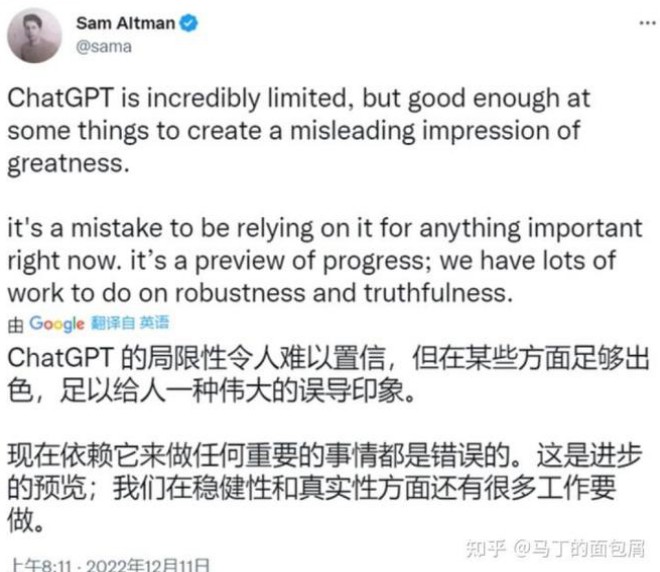

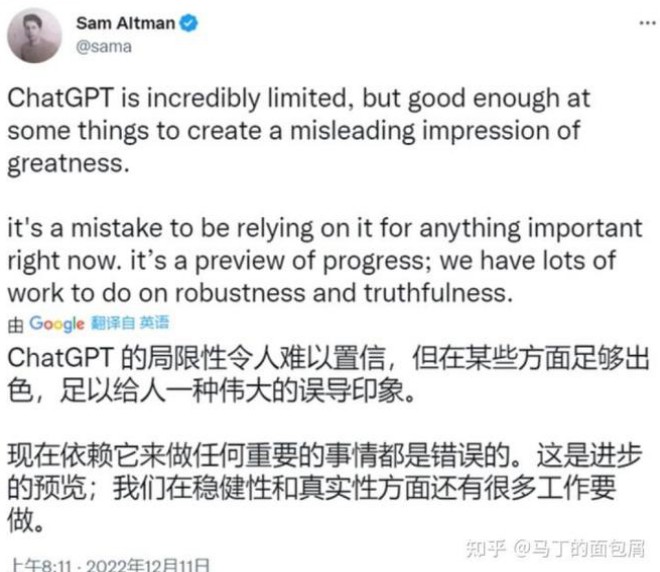

正是这些技术的巧妙结合,使得Chept GPT在自然语言处理任务上取得了优异的表现。然而,Chept GPT并非完美无缺。例如,它在处理长文本时仍然存在性能瓶颈,且对于一些复杂任务,其表现仍不如人类。未来,随着技术的不断发展,Chept GPT等预训练语言模型有望在更多领域发挥重要作用,为

人工智能的进步贡献力量。